上海交通大学人工智能研究院首席科学家徐雷教授、浙江大学光电科学与工程学院副院长戴道锌教授、北京大学人工智能研究院类脑智能芯片研究中心主任杨玉超教授、上海交通大学物理与天文学院副研究员唐豪、

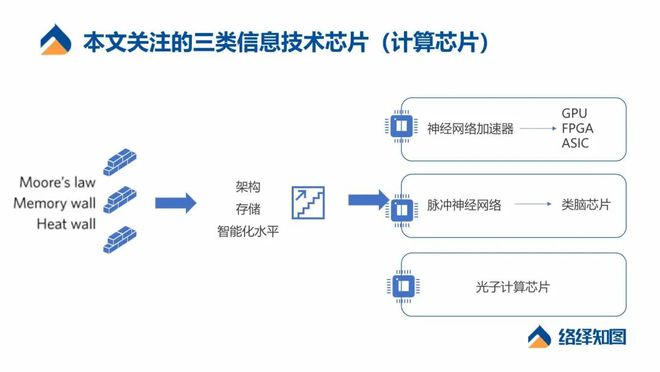

本文将结合论坛的重点内容和当前信息处理芯片的现状,对三种未来备受关注的信息技术芯片进行概念解读及产业分析。

在算力需求大幅提升的背景下,信息技术芯片所承载的计算处理能力不足,来源于架构侧、智能化水平、功耗、软件能力等多方面的挑战。

最早以 CPU 为代表的计算芯片采用的依然是传统的冯·诺依曼架构,存算分离是最大的特点,也是冯诺依曼架构的瓶颈所在。在计算之前需要从存储器当中读取数据,之后再进行计算。这个过程中,功耗和延时花费在搬运数据的环节上。从单次操作来讲,大多数情况下,搬运数据需要的功耗占据了整个功耗的约 70% 。解决这个问题最直接的思路,即是实现存算一体。

同时,存储器性能的提升远远落后于计算器性能的提升。由于冯·诺依曼瓶颈和存储墙的存在,导致存算分离架构下,算力的提升面临天花板。为了解决这种困境,更多类型的非冯·诺依曼架构芯片出现,例如类脑芯片、光子芯片等。

除了架构侧的限制,智能化水平的提升也趋势计算芯片向更智能的阶段迈进。2011 年,风险投资公司 Andreessen Horowitz 的普通合伙人 Marc Andreessen 在《华尔街日报》上发表了一篇非常有影响力的文章,名为“ Why Software Is Eating the World-软件为何在吞噬世界”。十年后的今天,我们正站在“Deep Learning is Eating the World-深度学习正在吞噬整个世界”的节点。

基于人工智能的自然语言处理、图像识别和自动驾驶的技术进步,是以消耗计算资源和能源为代价的。工程师和计算机科学家正在付出巨大的努力,以找出更有效地训练和运行深度神经网络的方法。这也是未来计算芯片升级和演化的主要目的,为了让其更好地执行 AI 计算。

第三代神经网络技术预计向类脑脉冲神经网络技术演进,对更高智能水平的人工智能技术的需求,也驱使计算平台的架构升级和智能化升级。

不难发现,人脑是自然界中存在的典型高智能、低功耗的单体计算平台。类脑芯片则是典型的存算一体、高度智能化的计算架构。全球范围内对类脑智能和类脑芯片的研究,已经是非常重要的前沿课题。

面对算力需求的提升和人工智能水平的发展,对于信息技术芯片的代际演化来说,近期以面向数字神经网络的加速器(GPU / FPGA / ASIC 芯片)为主流解决方案;中远期,类脑芯片是解决方案之一。除了集成电路芯片的算法、器件、工艺等突破是解决算力问题的方法之外,集成光子芯片的研发也是解决算力瓶颈的有效路径。

在 CPU / GPU 设计领域,中国起步较晚,在技术水平和产业规模化方面远落后于国际先进水平。但受益于云计算、边缘计算、数据中心等计算需求增加,物联网等多场景对高性能高算力芯片提出更高要求,国产替代等因素,中国在 CPU / GPU / FPGA / ASIC 技术提升和国产化速度方面加速前进。

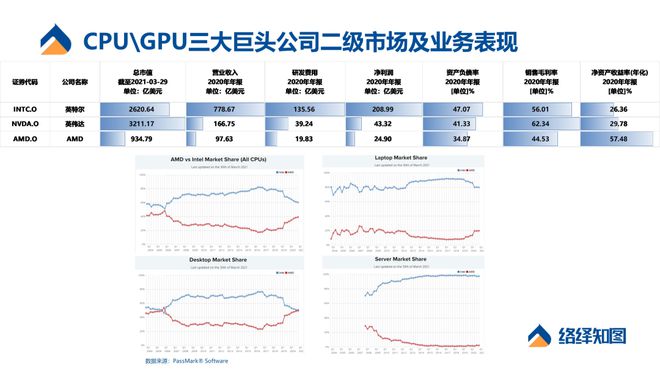

全球 CPU 市场整体被Intel和AMD占领。无论从营收规模,台式机、笔记本、服务器细分市场占有率来讲,Intel 远超 AMD(如图 2 所示)。

经过数十年探索,国产 CPU 产业已初具规模,中国六大国产 CPU 芯片厂商为——以 ×86 架构为主的复杂指令集(CISC)下,有海光(×86)、上海兆芯(×86);涉及 ARM 架构、MIPS 架构、Alpha 架构的精简指令集(RISC)下,有华为鲲鹏(ARM)、天津飞腾(ARM)、龙芯(MIPS)、申威(Alpha)。

图 2丨Intel、NVIDIA 及 AMD 的部分财务数据(数据来源:财报、PassMark,络绎知图整理)

现阶段适合神经网络计算的加速器最常见的解决方案是 GPU,GPU 本质上来说依然是先进的冯 · 诺依曼架构。

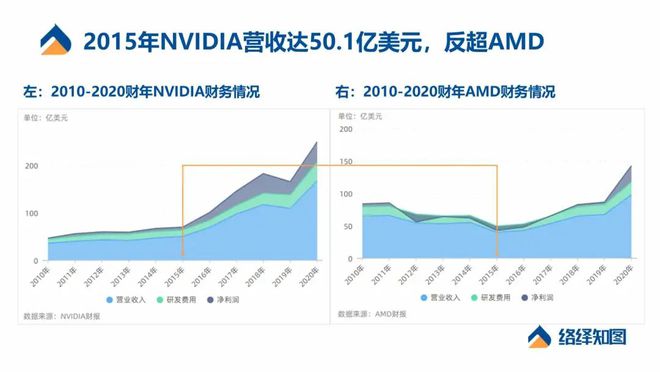

三驾马车奠定 NVIDIA 在 GPU 市场的霸主地位。长期以来,游戏显卡业务功不可没,游戏部门为其创造了确定的业绩增长与健康的现金流,2015 年 NVIDIA 营收首次超越 AMD。之后 NVIDIA GPU 在数据中心业务中又获得一轮爆发式增长。

此外,在阿里云、AWS、Microsoft Azure 及 Google Cloud 厂商中,NVIDIA 的市场份额大幅领先于 AMD 等一众厂商,NVIDIA 在全球主要云厂商中占据绝对领先地位。像 Amazon 和Microsoft 这样的大型云厂商,在计算芯片上投入了大量资金来支持机器学习算法,Google 也在研发自己的专用机器学习芯片。

除此之外,NVIDIA 市值和业务最有想象空间的还是自动驾驶计算平台(汽车中控计算芯片)。同时整个计算芯片市场的主要增长动力预计也将从数据中心,转移到自动驾驶汽车。

Intel(英特尔):成立于 1968 年的英特尔,崛起于 PC 时代,创办人之一的 Gordon Moore 提出了半导体产业经典的摩尔定律。面对异构计算架构时代,英特尔以 “ SVMS 架构”应对,发布多款 FPGA 产品。今年 3 月,英特尔宣布重启晶圆代工服务,重回 7nm 晶圆制程技术战场。

NVIDIA(英伟达):NVIDIA 正在加速从芯片到 CPU 和 GPU 的连接方式,再到整个软件堆栈,以及最终跨整个数据中心的性能提升。2020 年发布了首款安培架构 GPU——NVIDIA A100,单片 A100 包含超过 540 亿个晶体管,使其成为世界上最大的 7nm 处理器。同时发布 NVIDIA DGX A100 系统,单节点 AI 算力达到创纪录的 5 PFLOPS,5 个 DGX A100 系统组成的一个机架,算力可媲美一个 AI 数据中心。

AMD:AMD 于 2020 年正式推出锐龙 5000 系列台式机处理器,采用全新“ Zen 3 ”核心架构,这是自 AMD 2017 年推出 “ Zen ” 处理器以来提升最大的一次。得益于 IPC 和频率的双重提升,AMD 锐龙 9 5900X 也是首款默认设置下 CineBench R20 单核心分数超过 600 的台式机处理器。

中科曙光(Sugon):中国中科曙光依托中科院科研实力与产业资源,掌握大量高端计算机、存储和云计算等领域核心技术,九次摘得中国超算 Top100 份额第一,在 2019 年第 54 届全球超算 Top500 中以 71 套系统并列第二名,在国内高性能计算市场绝对领先份额。

兆芯(Zhaoxin):中国上海兆芯同时拥有 CPU、GPU、芯片组三种 IP 及芯片自主研发能力,开先 KX-6000 和开胜 KH-30000 系列处理器基于 16nm 工艺,是国内首款主频达到 3.0GHz 的国产通用处理器。

景嘉微(JINGJIA MICRO):中国长沙景嘉微是国产 GPU 代表力量,2020 年预计实现营业总收入 6.54 亿元。在图形显控领域,以 JM5400 研发成功为起点,研发国产高性能低功耗图形处理芯片。第二代 GPU 芯片 JM7200 流片成功,采用 28nm 工艺,已完成与龙芯、飞腾、麒麟软件、国心泰山、道、天脉等国内主要的 CPU 和操作系统厂商的适配工作。

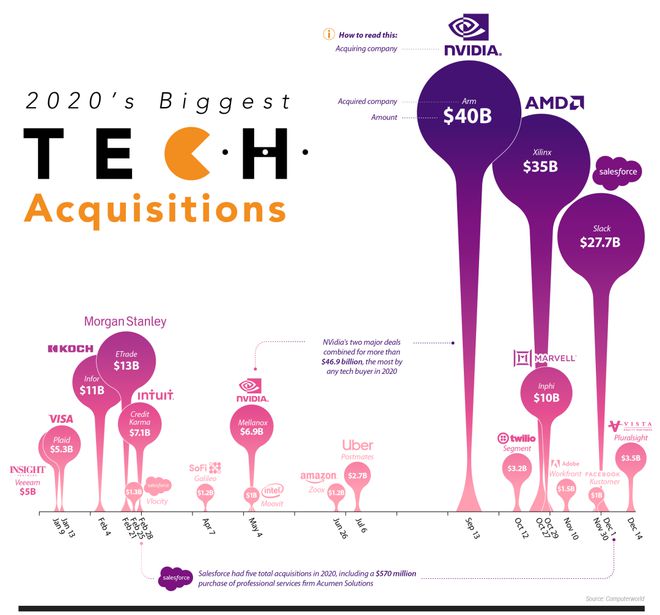

回顾 2020 年并购交易额超过 10 亿美元的 19 笔交易,大多数并购活动集中在半导体领域。Salesforce 和 NVIDIA 是唯一进行多次重大收购的公司(如图 4 所示)。

除了 CPU 之外,GPU、APU、TPU、FPGA(现场可编程门阵列)、ASIC(专用集成电路)等多种类型的加速器芯片正扮演着愈加重要的角色。在许多情况下,这些加速器与 CPU 等芯片一起工作,用于加速某些对应用至关重要的任务,例如计算机视觉应用中的图像识别。多种芯片协同工作的架构通常称为异构计算。

FPGA(现场可编程门阵列)是一种灵活的半导体芯片架构,能够在产品设计完成,甚至在投入现场使用之后进行更改或更新(由此得名)。FPGA 的设计初衷是成为 ASIC(专用集成电路)更灵活的替代品龙8long8。

有些 FPGA 专门用于高性能、数据密集的工作场景,如云端数据中心,这时它们需要的运行功率高达几百瓦;有些则用于小型、低功耗的设计,其功耗可能低至 1 毫瓦(千分之一瓦);还有些介于两者之间。由于它们本身非常灵活,可应用于各类广泛的环境。

以云端数据中心为例,微软一直都在使用高功耗的 FPGA 来加速 Bing 搜索引擎的速度。在此应用中,FPGA 与 CPU 协同工作来加速微软针对必应开发的特定搜索算法。这类高功耗的 FPGA 多由 Xilinx 和 Intel 提供。

而在一些无人机、安防摄像头和可穿戴产品等消费电子应用中,以及预测性维护、马达控制和机器视觉等工业应用中,小尺寸、功耗更低的 FPGA 正适配于网络边缘计算设备上去运行基于人工智能的软件算法。

在未来十年内,汽车自动驾驶是 FPGA 最重要的一个探索和应用场景。不仅因为 FPGA 灵活的内部架构,它还能很好地适用于特定的连接功能,尤其是连接各类不同的信号输入。除了在车载信息娱乐系统中显身手外,FPGA 开始扮演一些新角色,作为多路数据的聚合器。

但由于 ASIC 一旦设计并生产出来,它的功能基本不能修改,除非重新设计和构建全新的芯片。且 ASIC 设计起来比较困难、价格高昂,在实际通用场景下比较少见。随着时间推移和场景侧的落地,未来专用于自动驾驶侧的 ASIC 芯片有可能成为主流方向。

全球主攻 FPGA 市场的企业中,除了有 Xilinx 和 Altera 双雄之外,Lattice也是专做 FPGA 的上市公司。中国主攻 FPGA 的创业公司有安路科技和高云半导体。

巨头Intel也是 FPGA 的强有力竞争者,英特尔不仅是 CPU 王者,又收购了 Altera,在 FPGA 领域布下一子。综合来说,Intel 的计算芯片在汽车自动驾驶市场中的采用率,处于主流位置。不仅自动驾驶 FPGA 芯片已经量产,还收购 Mobileye 这家全球领先的视觉 ADAS 厂商,仅有自主的专有软件算法,以及 EyeQ 芯片。

Lattice:低功耗 FPPA 市场的有力竞争者。长期盘踞消费电子市场的 Lattice 逐渐将触手伸入工业和汽车领域,更加侧重于边缘端、嵌入式、低功耗、小尺寸的产品设计开发上。

安路科技(ANLOGIC):成立于 2011 年,大基金、华大半导体加持的 FPGA 创业公司,侧重工业市场。于 2015 年推出其第一代 FPGA AL3-10,当前已经形成了从几百个逻辑单元 CPLD 到 400K 逻辑单元 FPGA 全系列布局。

高云半导体(GOWIN Semiconductor):2015 年一季度量产出国内第一块产业化的 55nm 工艺 400 万门的中密度 FPGA 芯片,并开放开发软件下载。至今五年时间陆续推出两大家族,100 多种封装的 FPGA 芯片,例如集成 PSRAM 的 FPGA,蓝牙 FPGA、GOAI 等创新尝试。

人工智能中神经网络模型的一个重要特点就是计算量大,而且计算过程中涉及到的数据量也很大,因此对高算力和低能耗的要求极高。目前采用冯·诺伊曼架构的主流处理器系统能耗过高、认知任务处理能力不足,无法完全满足这种要求。在这样的时代背景下,打破冯 · 诺伊曼架构的束缚就成为了必然的趋势。

人脑是非常理想的计算架构参考对象。人脑约有 1000 亿个神经元和 100 万亿个突触,能够在极低的能耗下,完成复杂的关联记忆、自主识别、自主学习等认知处理。这是基于脑神经网络的多层次复杂空间结构和脑神经的高度可塑性。

类脑芯片则是典型的非冯 · 诺伊曼架构。类脑计算架构的核心正是借鉴人脑信息处理方式,将存储和计算一体化,能够实时处理非结构化信息,具备自主学习能力,同时满足超低功耗的需求。

目前市场上尚未出现量产的可商用的类脑芯片,但已有很多国家和机构在类脑计算研究和产业化领域探索了多年。海外类脑计算芯片产业化道路走在最前面的代表有两家公司:IBM和Intel,他们发布了两款全数字类脑计算芯片。

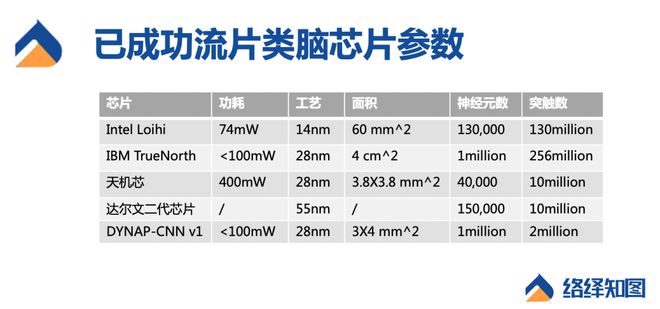

2014 年,IBM 推出了神经网络推断芯片 TrueNorth ,它借鉴神经元工作原理及其信息传递机制,实现了存储与计算的融合。该芯片包含 4096 个神经突触核心,每个核心包含了 256 个神经元和 6.4 万个突触,合计约 100 万个神经元和 2.56 亿个突触。

TrueNorth 芯片的功耗低至仅 70 毫瓦,比传统处理器低了 4 个数量级。更形象的来说,这相当于一款邮票大小的神经突触原理超级计算机,并且仅用一块智能手机的电池就可以维持工作近一周时间。TrueNorth 芯片的功率密度也做到了 20 毫瓦/平方厘米,接近脑皮层的水平,同样相比于 CPU 低了 3-4 个数量级。

TrueNorth 芯片同时具有很好的扩展性,能通过外部连接组成更加复杂的硅基神经网络系统。2018 年,NS16e-4 系统问世,它集成了 64 个 TrueNorth 芯片,神经元数量达到了 6400 万个。根据 IBM 官网介绍,依托 TrueNorth 可以扩展出拥有 10 亿神经元、2560 亿神经突触的超级计算系统,然而功耗仅相当于一台桌面计算机。

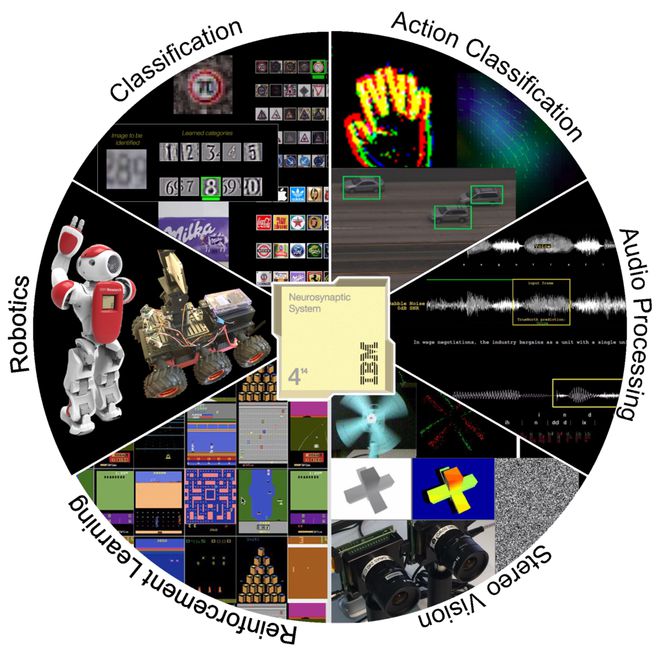

IBM 也正在探索 TrueNorth 芯片在多个领域的应用潜力,包括:运动归类龙8long8、音频处理、立体视觉、强化学习、机器人、分类等。

2017 年,Intel 推出了支持片上学习的 Loihi 脉冲神经网络芯片,每个芯片包含 128 个神经形态核心和 3 个× 86 处理器核心,总计 13.1 万个神经元。与 TrueNorth 芯片类似的是,Loihi 芯片同样表现出了非常好的可扩展性。

根据 Intel 官方披露,英特尔的 Pohoiki Springs 等神经拟态系统仍处于研究阶段,龙8游戏官方进入其设计目的并非取代传统的计算系统,而是为研究人员提供一个工具来开发和表征新的神经启发算法,用于实时处理、问题解决、适应和学习。

目前,Loihi 芯片的应用在以下几个领域表现出了更快的运算速度和更低的能耗:语音命令识别、手势识别、图像检索、优化和检索、机器人。

中国的类脑计算研发也产生了显著的成果,这其中包括清华大学的“天机芯”、浙江大学的“达尔文芯片”以及创业公司 SynSense时识科技。

2019 年 8 月,清华大学施路平教授团队在《自然》期刊以封面文章发表首款异构融合类脑计算芯片——“天机芯(Tianjic)”。“天机芯”采用多核架构,由 156 个单功能核(FCore)组成,包含大约 4 万个神经元和 1000 万个神经突触。

而所谓异构融合,指天机芯的架构打破了基于计算机科学的人工智能和基于神经科学的人工智能的壁垒,成为一个通用的平台,在算法层面上即支持目前主流的人工神经网络模型(Artificial Neural Network,ANN)也支持脉冲神经网络模型(Spiking Neural Network,SNN)。

基于天机芯的无人自行车展示了可以实现语音识别、自平衡控制、探索跟踪、自动避障等功能。之所以选用无人自行车作为展示工具,是因为它是一个类似大脑的多模态系统,能够覆盖感知决策和执行的完整的链路,为异构融合的多种模型提供支撑;同时不同于在实验室或者电脑中做仿真,无人自行车也体现了与真实环境的交互。这一项研究成果也被评选为“ 2019 年中国十大科技进展 ”。

从清华大学类脑计算中心科技成果转化而来的灵汐科技,目前也已经获得了来自中电海康、广发信德、优选资本、华控基石等机构的多轮融资。施路平教授担任灵汐科技的联合创始人。

2015 年,浙江大学牵头研发了达尔文一代芯片,这是国内的首款类脑芯片,拥有 2048 个神经元,4 百万个神经突触。2019 年 8 月,达尔文二代芯片问世,这是一款主要面向智慧物联网应用的芯片,单芯片由 576 个内核组成,拥有 15 万神经元、1000 万个神经突触,在神经元数目上已经与果蝇相当,典型应用功耗约 100 毫瓦。

2020 年,浙江大学宣布了包含 792 颗达尔文二代芯片的类脑计算机 Darwin Mouse 研制成功,这一款类脑计算机支持 1.2 亿脉冲神经元、720 亿神经突触,与小鼠的大脑神经元数量规模相当,典型运行功耗只需要 350-500 瓦。

SynSense 时识科技是一家类脑芯片、智能传感器设计与开发公司,于 2017 年 2 月在瑞士创立(原名 ai-CTX),现已在国内落地。公司技术起源于由苏黎世大学和苏黎世联邦理工学院联合发起的苏黎世神经信息研究所,核心技术 DYNAP (Dynamic Neuromorphic Asynchronous Processor)帮助可配置、通用、实时响应的神经网络在脉冲神经元中的实现。

DYNAP-CNN是全球首款动态视觉专用处理器芯片,于2019年成功流片。该芯片由异步电路设计,拥有100万脉冲神经元,200万突触,可以直联动态相机(DVS)完成多种实时视觉识别及交互类任务,典型任务场景下功耗可低至1mW。

创始人乔宁博士毕业于中国科学院半导体研究所,曾在苏黎世大学从事博士后研究工作,现任苏黎世大学助理教授。目前,时识科技已经获得了百度风投、默克、和利资本等投资机构的多轮融资。

除了以上基于硅技术的类脑计算芯片,还有一部分类脑计算芯片的研究方向是基于新型纳米器件和技术,以忆阻器阵列为代表。这种芯片直接利用定制的器件结构,来模拟生物神经元的电特性,集成度更高,是非常有潜力的类脑计算芯片方案。但是,让忆阻器阵列完整实现芯片的功能,尚需要解决工艺、系统、算法等一系列的未知难题。

在这一方面,中国学者的研究成果也走在了世界的前沿。2020 年,清华大学钱鹤、吴华强教授团队等合作研发的基于多个忆阻器阵列的存算一体系统发表在《自然》期刊上,他们在该系统上高效运行了卷积神经网络算法,成功验证了图像识别功能,能耗高出 GPU 两个数量级,实现了以更低的功耗和硬件成本完成复杂的计算。这项研究成果证明了利用忆阻器实现存算一体的可行性。

类脑芯片的发展,经历了从纯数字到数模混合、从单芯片的集成到系统级的集成、从片外学习到片上学习的转变趋势。

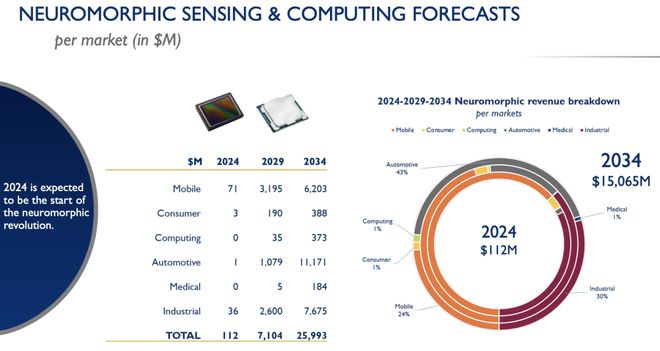

类脑计算的发展未走出前期的实验室研究阶段,离工业界的实际应用仍有一定的距离。根据 Yole 报告,类脑计算最快可能将于 2024 年前后成熟,我们相信到那时类脑计算芯片表现出的相比于冯·诺伊曼架构的 AI 芯片的优势将会带来巨量的产业发展机会。

与电子计算时代的集成电路芯片的物理结构演化路径一样,在光子计算语境下,光子芯片就是将大量分立光路元件集成在光子芯片上,以实现更高的稳健性和可扩展性。

光子芯片的核心是在硅基上实现光子集成芯片,是在传统 CMOS 芯片上蚀刻微米级别的光学元器件。而光子计算,其实是一个古老的技术领域。作为一种完全不同于电子计算的技术,光子计算以光子为信息处理载体,依赖光硬件而非电子硬件,以光运算代替电运算,擅长快速并行处理高度复杂的计算任务。

硅光技术的理念是“以光代电”,但受限于传统分离式光子器件,具有光场调控手段单一、光子设计体积庞大的缺点。光子计算一直没有明确的应用场景,多数都停留在实验室阶段。Lightelligence(曦智科技)联合创始人兼 CEO 沈亦晨曾表示,光计算和光子芯片是最适合下一代计算芯片基建技术的选择。

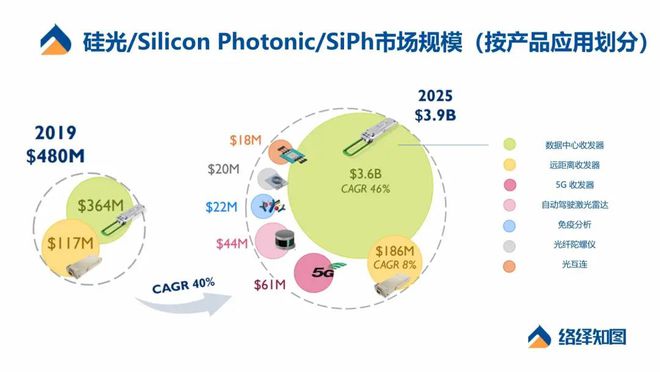

根据 Yole 数据,按照产品应用场景分类,2025 年硅光子市场规模将由 2019 年的 4.8 亿美元增长至39 亿美元。光通信仍然是硅光子最重要的应用,数据中心通信是硅光子的最大市场。

通信、互连场景下,硅光收发器市场的竞争长期存在,其中的巨头先行者是 IBM 和 Intel,主要是为了改善数据中心数据交换时的速率问题。此外,Luxtera(被思科收购)、Acacia、Fujitsu、Inphi、Rockley Photonics 及 NeoPhotonics 等公司都是硅光芯片领域的有力竞争者。

硅光芯片除了在数据中心、通信、传感和医疗领域的应用,还有一个非常值得期待的应用是光计算。AI 所掀起的计算需求不断膨胀,带动了市场针对特定计算推出更适合的新架构,比如上述的类脑芯片。而在能够延续现有成熟半导体工艺技术上,光子芯片的优势又更为明显。

需要明确的一点是——光子计算≠光量子计算。光子计算基于波动光学进行精准调制;后者则是用光子编码实现两种状态叠加的量子比特,无法用经典波动光学描述的量子光学。

全球范围内,光计算芯片处于非常早期的阶段。从当前时间节点来看,以美国和中国为代表的光子计算公司仍在进行技术和产品上的探索,且商业化并不成熟。虽然离实际应用还需要一定时间验证,但总体来说中国是非常有机会走在世界前列的。

在利用光进行神经网络计算的领域中,有一些正在探索的公司,如Lightmatter,Fathom Computing,Lightelligence(曦智科技),LightOn,Luminous 和 Optalysis。将光计算应用于脉冲神经网络,该网络利用大脑神经元处理信息的方式,也许可以解释为什么人脑仅用十几个神经元就能出色地完成工作。

Lightelligence(曦智科技):诞生于 MIT,成立于 2017年,2019 年 4 月正式发布了全球首款光子芯片原型板卡,2021 年全球首款商用光子芯片即将问世。用光子芯片运行了 Google TensorFlow 自带的卷积神经网络模型来处理 MNIST 数据集,整个模型超过 95% 的运算是在光子芯片上完成。光子芯片处理的准确率已经接近电子芯片(97% 以上),另外光子芯片完成矩阵乘法所用的时间是最先进的电子芯片的 1% 以内。

整体来看,计算芯片的代际演进,服务于 AI 算法和智能水平的提升。当前,全球支柱性、智能化产业的信息处理环节进入算力竞争时代。更多类型的非冯 · 诺依曼架构芯片将会涌现并逐渐产业化。络绎知图也将持续关注计算芯片产业及前沿技术变革,为芯片产业与技术研究、投融资顾问、政策对接等专业服务贡献力量。

络绎知图是集科技数据、智能分析、学术服务于一体的科技大数据平台,以透视未来的科技本质为使命,面向学者、高校、科研机构以及从事科研成果转化的相关群体,提供研究型数据库、分析工具、学术会议、学术社区等功能,并通过媒体传播原创研究有效放大学术研究的影响力。